Stránka 3 z 4

Napsal: ned led 10, 2010 9:41 am

od swarm

DOC_ZENITH/XAN píše:Že je o 20% lepší po 2 letech? Mam se radovat?

Pokud jde o mobilní variantu, tak ta se začala objevovat až postupně během minulého roku. V ČR jsem měl možnost něco s ní testovat až někdy Q3 2009. Pokud tuhle přejmenovanou začnou teď rychle chrlit do notebooků, tak to zdaleka "2 roky" nebudou.

Btw mluvilo se tu o nadvládě ATI v noteboocích. To teď právě končí. 80% nově ohlášených notebooků s dedikovanou grafikou vsadilo na nvidii.

Napsal: ned led 10, 2010 12:26 pm

od no-X

socket píše:no-x: neviem teraz najst to, kde si tvrdil ze G80 na 90nm je nezmysel, ze tak velky cip proste musi mat takmer nulovu vytaznost. A to G200 este zvysila plochu (65nm).

GT200 mohla snadno zvýšit plochu, byla vyráběná na jiném výrobním procesu. G80 byla vyráběná na 90nm a využila maximum, které 90nm proces dovoloval. Tohle jsem tvrdil jako reakci na zprávy o obrovském výkonu před tím, než se objevily informace o tom, že polovina jádra poběží na >2x vyšší frekvenci. S tím se počítat nedalo a bez toho by buď čip s takovým výkonem na 90nm procesu nemohl být vyráběný (protože by byl přes limit), nebo by zkrátka takový výkon neměl.

Mimochodem, čím to, že tolik lidí blábolí nesmysly od rána do večera, ale když se v jedné věci seknu já, je mi to připomínáno ještě po třech letech?

DOC_ZENITH/XAN píše:Myslím si že rozdíl mezi G71 a G80 byl více jak 80%. Teda obě karty jsem měl a musim to potvrdit. Jo, možná v 1024x768 no AA no AF a maximální optimalizace takže se na to nedá koukat, pak by to bylo 80%. Ale zkuste si s G71 spustit moderní hru v 1920x1200 s rozumnym nastavenim, bude to tak 4x horší jak G80.

Všechny ty rozdíly mezi kartou "A" a kartou "B" jsou vždy převzaté z computerbase z recenze karty "B". Jsou to vždy výsledky s AA(4x)/AF v rozlišení, které se v dané době považovalo za typické pro jednočipový high-end (nejvyšší nebod ruhé nejvyšší v testu).

Chápu, že s odstupem X let mohou být výsledky jiné, ale pokud mluvíme o tom, jaký je rozdíl ve výkonu u nových čipů (tzn. těch, které jsou na trhu dva měsíce), nemůžeme srovnávat jablka a hrušky.

DOC_ZENITH/XAN píše:Jinak ještě k HD2900XT vs 4670. dle toho co jsem zkoušel je 4670 znatelně slabší, neberu teď staré hry kde je potřeba hodně fillrate a se zapnutym FSAA protože to je přesně to co R600 zabijí, ale jednoduše zkusil jsem si Crysis no AA na obouch krtách a bylo celkem jasno.

Je to srovnání s AA/AF ve stejné situaci, jako jsem popsal v předchozím odstavci. On nikdo pomalé AA R600 neodpustil, takže by asi bylo trochu zavádějící, kdybych pro jednu kartu dělal výjimku.

DOC_ZENITH/XAN píše:Přinesla jako první hodně nízkou spotřebu v 2D, excelentní power management...

No, to byl z poloviny marketing. Spotřeba ve 2D sice klesla, ale v praxi karta ve 2D měla víc než o polovinu vyšší spotřebu, než kolik nVidia uváděla ve slajdech.

G80 byla "revoluce" ze dvou důvodů - G71 byl malý čip, zastarý a krom nízké spotřeby to byla sra*ka. A ATi měla své problémy s R600, které ještě zkomplikovalo sloučení s AMD, takže neměla konkurenci - když vyšla, byla zabugovaná až běda. Kdyby nebylo všemožných komplikací a konkurence přišla včas a v rozumné podobě, nebyla by G80 brána jako žádná revoluce.

Od té doby je situace vyostřená, takže nVidia raději vydává obrovské čipy jenom aby se nestalo, že by ATi mohla mít něco o půl procenta rychlejšího... a přechodem z velkého (výkonného) čipu na cokoli nového revoluci neuděláš. Představ si situaci, že by nVidia nevydala GT200, ale po G80 už zůstala u G92. To by byla podobná situace jako s G70->G71. Doteď bychom na trhu měli RV770 a G92b a když by ATi přišla s RV870, vypadalo by to jako stejná "revoluce", jako s G80.

Tohle není o reálném výkonu, nebo konkrétních produtkech, ale o kombinaci toho, co je na trhu a dalších událostí (něco se někomu nepovede, něco se někomu povede, časově se to sejde a jeden produkt to v očích zákazníka katapultuje výš, než kam byl mířen).

Napsal: ned led 10, 2010 6:41 pm

od DOC_ZENITH/XAN

Jak byla G80 zabugovaná, teda, myslim HW zabugovaná, co tam je a nefunguje? O ničem kritickym nevim. Furt lepší jak ATI a jejich Gigaflopy které nikdo neviděl a nakonec se ukáže že jsou asi tak reálné jako cpu bez L1 cache. Když srovnám teoretický výpočetní mimoherní výkon třeba GT200 a Rv770, je na tom Rv770 lépe, v praxi ale ta GT200 dosahuje tak 40% svého teoretického výkonu a rv770 tak 5% to se mi normální nezdá. Ano hodně lidí tvrdí že drivery to opraví, ale jestli budem čekat jako u R600 tak než to opraví tak bude na trhu další refresh R8xx...

Ad ještě G80 vs G92... no... G92 byla výkonem horší, ale jen nepatrně a jen někdy a aspoň držela kvalitu obrazu. G71 byla oproti G70 ořezanej čip na texturovacích jednotkách, trpěla mnohem horšim shimmeringem, ale zas měla v benchmarkách lepší výkon. G71 měla jen jeden problém, vzhledem k výkonu a vlastnostem totálně přemrštěnou cenu. Ale i přes to že ATI na tom bylo líp, tak si NV musela tehdy pěkně namastit kapsu protože ty 7900GT/GS/ 7950GT a podobný, těch je mezi lidma tuna a ten čip byl fakt hoodně levnej.

Jo a ještě k 2D spotřebě GT200, to jsi vlastně sebral kde, krom jedný recenze totiž všude kde to měřili potvrdili opravdu hodně dobrou 2d spotřebu, znatelně lepší než má třeba G92 55nm.

Napsal: ned led 10, 2010 7:10 pm

od Bob van Sikorski

vyšší (vysoká?) spotřeba ve 2D u GT200 se už řešila vícekrát, kdykoli ji komukoli mohu potvrdit na 55nm MSI GTX260.

Napsal: ned led 10, 2010 7:14 pm

od Lukfi

=>XAN: zabugovaná byla R600.

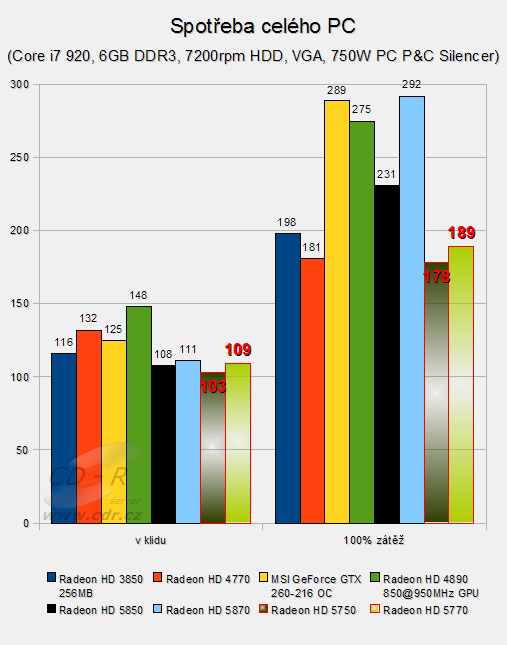

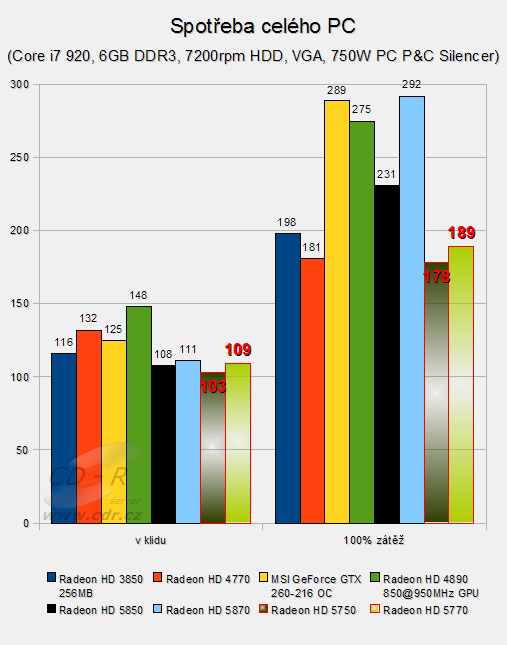

HD 3850 a HD 4770 - obě úsporné karty, za spotřebu někde mezi nimi se GT200 vůbec stydět nemusí.

Napsal: ned led 10, 2010 9:59 pm

od no-X

Lukfi: jasně, ale neodpovídá to specifikacím, které nVidia uváděla... když mě na to BvS upozornil, prohledal jsem několik recenzí a skutečně to často vychází výrazně výš, než jak nVidia slibovala...

ale to teď někdo zmiňoval i beyond3d ohledně spotřeby ve 3D - v majoritě testů vychází u nVidií vyšší max. spotřeba, než je uvedeno ve specifikacích

Napsal: pon led 18, 2010 10:47 pm

od Lukfi

Zaujalo mě, co psal XAN ve vedlejším tématu a myslím, že se to lépe hodí tady:

Co si myslíte, změní konečně DX11 to jak vývojáři dělaj hry? Budou se složitý modely generovat až v GPU a ne v CPU a pak posílat GPU? Dokud budou multiplatformní hry tak se současnou generací konzolí asi ne, ale mohlo by se to stát.

Jak moc je vlastně odlišné udělat hru, která bude využívat tesselaci? Totiž, v techdemech, co na to zatím jsou, to vypadá tak, že tam je jeden objekt, který má v jednom stavu velice nedokonalý geometrický model a ve druhém stavu, s tesselací, krásně detailní. Pokud by to v nějaké hře bylo takhle ve velké míře použité, jak by to pak vypadalo na starším hardware? Použily by se ty detailnější modely, s tím, že se s tou složitější geometrií holt bude muset poprat CPU, nebo by se použily ty základní, málo detailní modely, jako je to vidět v techdemech, a ve výsledku by to na starších kartách vypadalo jak z roku raz dva?

Napsal: pon led 18, 2010 11:07 pm

od DOC_ZENITH/XAN

Takhle, myslím si že jednu věc máš zafixovanou naprosto špatně. A to, že teselace dělá detailnější obejkty. Ne, nedělá. Teselace jen zvětšuje počet polygonů tak, aby nebyly výrazné zuby hran, aby hlava nebyla šišatá i když je to low-poly model. Pozitivní na tom je, že že toto neatěžuje niak CPU, celej proces se uděje v GPU a CPU o tom ani neví, ten furt tvoří ten low-poly model a ten pošle do GPU + příkaz že se na něm má provést teselace.

Rozdíl mezi tou DX11 certifikovanou teselací a tou z dob starejch radeonů je ten, že tato nová je plně programovatelná, tudiž nenastávaj problémy jako dříve, že to zaoblilo i hrany které měly zůstat ostré, teď se dá přesně napsat kdy a jak a kde to má zapracovat. Ale nikdy! To neudělá detailnější model.

To co vididíš v tom tech demu na teselaci, nebo pokud jsi viděl to 1080i video z toho novýho AVP, tak je jen jeden obrovskej fake/cheat na vyzdvihnutí teselace. Ano, používá se tam, ale oni tam nahrazujoi i ten model za jinej. Pokud má originální model rovnou střechu, teselace tam tašky nevymodeluje. Teselace by pomohla pokud by tam už byly ale hnusný a kostrbatý. To samý ty schody, to kulatý okno. Teselace by z hranatýho okna co mělo bejt kulatý udělal kulatý jak má bejt, ale rozhodně by ho nevymodelovala do předu, přidala spáry mezi skly, atd. To samé v tom AVP, tam taky když to člověk pomalu sleduje, tak je jeden model a najednou se přiblížíš do jiný hladiny LOD a aplikuje se úplně jinej model, kterej má drápy navíc, prostě totálně jinej model, tohle neni projev teselace. To je jako kdyby jsi oskenoval list papíru, zapnul teselaci a ona ti z něj vymodelovala vlašťovku...... a spousta lidí ti v tom i uvěří, bohužel...

K tomu aby se ti změnil i model na straně GPU, tak musíš použít ten "Displacement mapping" což prozkoumá texturu a dle jejich barevnejch vlstností aq tvarů změní 3D vlastnoti objektu, rovněž plně programovatelné. Kombinace tohoto a teselace už dokáže udělat svoje. Jak tohle ale přesně funguje (nebo má fungovat aby se to zároveŇ trochu hejbalo) na Rv870 vůbec nevim, na GF100 již bylo vysvětleno, ale dokud to neuvidim v praxi.....

Ale furt mě vrtá v hlavně ta otázka proč se už dávno modely nenanášej přes vertex shadery a furt je do háje zpracovává CPU, jako dnes už v minimálních specifikacích neni ta GF2MX nebo FX5200, tak proč hergot...

No proč, jednou se to tak v 90.tejch letech naučili a nechtěj se učit něco jinýho no. Dnes můžem bejt rádi když to aspoň udělaj multithreadově takže se to dá rozházet trochu rychlejc na dnešních CPU (třeba UE3 jede na dvoujádrovejch P4kách lépe než UE2.... s odpovídajícím GPU samo sebou), ale furt se nevyužívá ani 10% potenciál toho geometrickýho HW v grafický kartě. Já už vidim jak někdo bude mít božskou myšlenku ala hejt je to Cčkovej kód, fermi ho uí taky! Napíšeme ten geometry engine pro fermi, nebo OpenCL aby to jelo na všem! To bude hype, to bude bomba.... a já budu brečet, kdo to co zas vymyslel za sračku, protože zatěžovat to GPU takhle hrozně ala rvát do něj kód přes PCI-E tam, kód naprosto neoptimalizovanej pro GPU, jen prostě zpracovatelnej tou jeho brutforce, pak výsledek přes PCI-E zas spátky a pak do GPU klasickou cestou jako geometrickej model. Jestli se taková prasárna prosadí tak si snad koupim konzoli.

Proč to ale furt honěl přes CPU.. možná za tim bude lobing Intelu a AMD, ono totiž by je normálně nikdo nepotřeboval, i takový Via NANO by vše s přehledem zvládla. OS tam o CPU nejde tam jde o disk, videa s tim pomůže GPU, s flahem kterej brzdil browsování netu taky pomůže GPU ( viz tegra a flash ). Prostě pro běžný usery ala office + filmy + net + hry, by byl rozdíl mezi celeronem 2ghz a šestijádrovym Nehalemem nula nula prd pokud by systém měl dost ram a SSD disk se systémem. Přjde mi jen že je to skrytej lobing aby se to prodávalo.

To samý mi přijde s ramkou, proč do háje všechny textury na PC musej bejt i v RAM a ne jen ve Vram? Takový starý pravidlo DX... že prej kvůli rychlému přepínaní programů. Jo, ale v RAM nefungujou žádný HW kompresní algoritmy, tudiž to co má ve Vram 200mb má v ram přes 1gb. Proto dnes hra co běží na konzoli s 256mb ram a 256mb Vram chce na PC při stejnejch detailech 2gb ram sama pro sebe, nepočítám OS. Prostě humus velebnosti. To by byl průser kdyby všem stačilo 1gb... že....

Napsal: úte led 19, 2010 11:06 am

od no-X

DOC_ZENITH/XAN: Teselace může vytvářet i detailnější modely. To co bylo plackou, může proměnit v libovolně tvarovaný povrch - na to stačí textura, ze které se načtou údaje o výšce

Napsal: úte led 19, 2010 12:12 pm

od Lukfi

Takze namisto high poly modelu je tam low poly a textura - jak to pak bude vypadat na hw bez tess.? To tam budou jen ty lowpoly modely nebo se namisto tess. pouzije displacement mapping?

Napsal: úte led 19, 2010 12:31 pm

od no-X

teselaci lze využívat různými způsoby... je možné udělat jednoduchý model a teseslací "zaoblovat", nebo různé obdoby displacement mappingu. Případně použít teselaci a pokud jí čip nepodporuje, tak různé formy virtual displacement mappingu (třeba parallax occlusion mapping)

záleží, na co konkrétního jí autor chce využít a kolik úsilí tomu chce věnovat

osobně si myslím, že nejběžnější bude to zakulacování, a la n-patches... to dá nejmíň práce a lze ho snadno doimplementovat do téměř hotových nebo hotových her

Napsal: úte led 19, 2010 1:29 pm

od Lukfi

Mně se totiž zdá, že má vývojář na výběr takovéhle možnosti:

1) používat tesselaci hodně, na všechno možné, mít jednoduché základní modely

pokud nedobastlí jinou codepath na starším HW, nebude to vypadat pěkně

2) používat tesselaci jenom na drobné detaily, aby rozdíl mezi DX10 a DX11 byl jenom malý, kosmetický

Napsal: úte led 19, 2010 1:41 pm

od no-X

i tak se to dá shrnout

Napsal: úte led 19, 2010 1:46 pm

od Lukfi

Možná by nebylo od věci věnovat tesselaci nějaký krátký článeček. Takové základy, co to vlastně dělá, proč je to lepší než stávající metody, jaký to má dopad na výkon... marketing nVidie se svým "tesselation performance" to znásilnil takovým způsobem, že by se hodilo to nějak vysvětlit.

Napsal: úte led 19, 2010 2:15 pm

od no-X

S tím souhlasím. A kdo se toho ujme?

Napsal: úte led 19, 2010 2:26 pm

od Lukfi

Já bych se toho ujal docela rád, ale mám na to docela velké mezery ve znalostech

musel by mě někdo morálně podpořit a pak to po mě zkontrolovat před vydáním

Napsal: úte led 19, 2010 2:46 pm

od no-X

Myslím, že mně, Mirkovi a snad Krtqovi by nevadilo se na to před vydáním podívat...

Napsal: úte led 19, 2010 4:03 pm

od Lukfi

No, já to úplně hned psát nebudu, ještě mi zbývá jedna zkouška... takže mám ještě čas se tady vyptat, jestli jsem to celé dobře pochopil.

Tedy: GPU dostane od CPU geometrický model. Řekněme, že to bude domeček z Unigine a střecha bude úplně placatá. K tomu přijde do GPU cosi jako normálová mapa (jak se tomu správně říká, height map? jsou ještě jiné způsoby, jak tesselatoru říct, kde má co dělat?), podle které se tam vymodelují tašky. Od tohoto okamžiku dál pracuje GPU se složitějším geometrickým modelem, kde už je střecha vlnitá.

Na něčem jednodušším (na zdi) se dá 3D efektu docílit taky bump/normal/displacement/parallax mappingem, ale moc vysoké/hluboké věci se tím dělat nedají, protože při bočním pohledu je to pořád placaté?

Napsal: úte led 19, 2010 4:10 pm

od no-X

ano, při bočním pohledu - nebo pokud to má mít nějaký okraj / hraničit s něčím... tak tam to je vidět:

http://www.behardware.com/articles/770- ... -5850.html

taky se na tom nedají využít efekty jako SSAO nebo HDAO a některé typy stínů

Napsal: úte led 19, 2010 4:20 pm

od Lukfi

Díky, ty obrázky vysvětlují mnohé.